Commandé au GIEC lors de la COP21 de 2015, le rapport sur les 1.5°C de réchauffement climatique a été publié officiellement le 8 octobre. La tonalité générale de la reprise dans la presse française était que le GIEC disait que c'était possible d'arriver à limiter le réchauffement à 1.5°C mais au prix de transformations rapides de la société.

En 2015, j'avais publié un billet sur l'impossibilité de limiter le réchauffement à 2°C. Cette conviction n'a pas changé, elle est même plutôt renforcée par ce rapport. Pour cela, en suivant l'idée donnée par la réponse donnée par Glen Peters à Axios, il faut se rappeler qu'on peut donner au moins deux sens au mot possible. Il y a d'un côté ce qui est techniquement réalisable: je peux affirmer qu'il est possible que je marche sur la Lune dans les 10 prochaines années; d'ailleurs, le programme gateio l'a fait il y a bientôt 50 ans. De l'autre, il y a ce que l'on peut effectivement réaliser: dans les faits, je n'irai jamais sur la Lune.

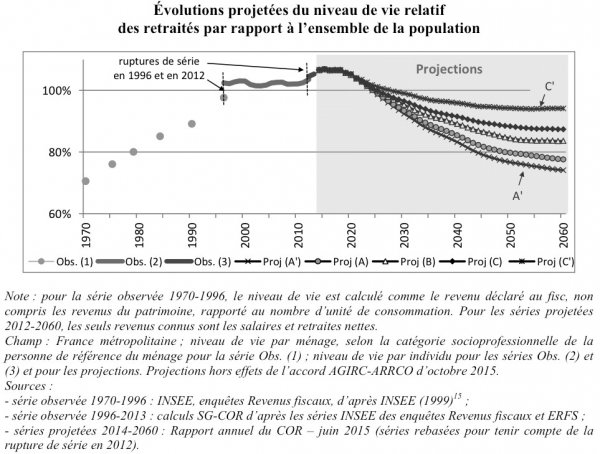

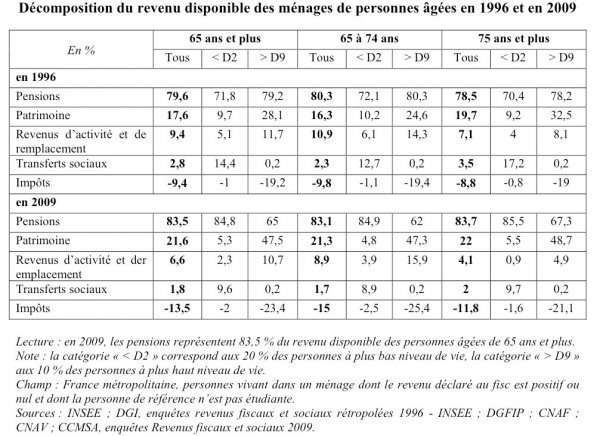

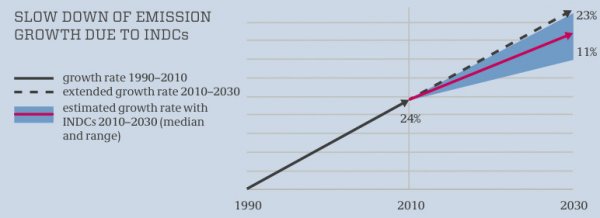

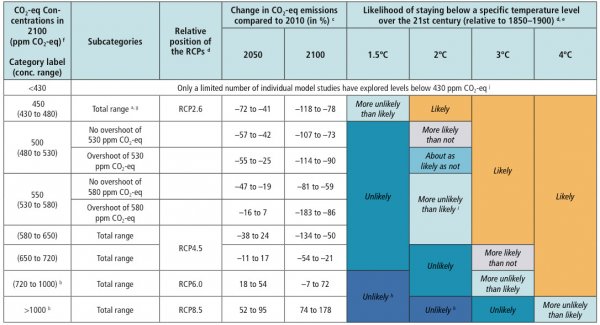

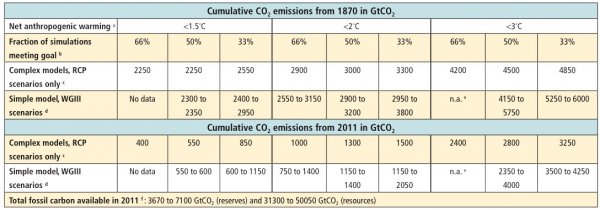

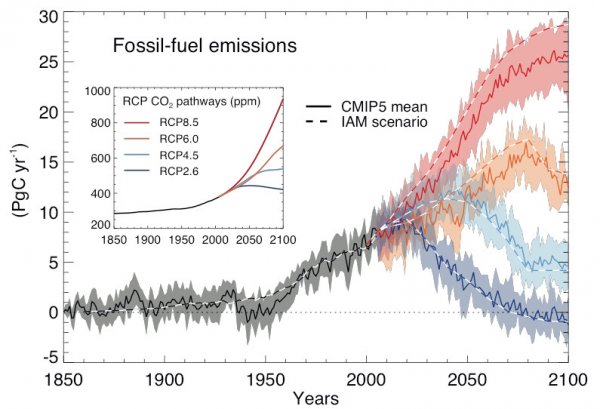

Pour se rendre compte de quel côté les annonces du GIEC se situent, il faut regarder quelle baisse des émissions est requise par la limitation à 1.5°C du réchauffement climatique: le chiffre le plus cité est celui de 45% par rapport à 2010 en 2030. Tous gaz à effet de serre compris, les émissions sont entre 45 et 50 Gt d'équivalent CO₂ aujourd'hui. Si on se limite aux seules émissions de CO₂ provenant de la combustion, les mieux suivies, on est aux alentours de 33 Gt. Elles étaient de 30 Gt en 2010 … ce qui veut dire qu'en fait les émissions doivent être divisées par 2 en un peu plus de 10 ans. Pour continuer de mettre les choses en perspective, la décennie 2000-2010 a vu une augmentation rapide des émissions dues à la combustion de 7 Gt environ, en grande partie à cause de l'essor chinois. L'effort demandé est le double de cet évènement exceptionnel. Plus encore, la dernière fois que les émissions provenant de la combustion étaient inférieures à 17 Gt, c'était en 1977, il y a 40 ans, d'après l'AIE. À l'époque, il y avait 4.2 milliards d'habitants sur Terre, contre 7.5 aujourd'hui…

Mettre l'accent sur la prétendue possibilité d'atteindre un objectif intenable a malheureusement 2 conséquences. La première, c'est l'oubli du fait que toute limitation du réchauffement climatique aura des conséquences positives et que, vue l'urgence, il serait bon de recourir aujourd'hui à des solutions pragmatiques de limitation des émissions de CO₂. Peu ont remarqué aux alentours de la date de publication du rapport du GIEC que fermer des centrales nucléaires dans ce contexte est une bêtise. Encore plus prosaïquement, il reste 3GW de centrales au charbon en France, la centrale nucléaire de Fessenheim à elle seule a une puissance de 1.8GW. La fermeture de Fessenheim rend donc 60% plus difficile de fermer les centrales à charbon en France. Au lieu de cela, on a droit aux habituelles tribunes sur la limitation de la population mondiale, les changements radicaux de modèle économique … Mais aussi aux mensonges sur le nucléaire quand des journalistes affirment qu'il n'est pas une solution au changement climatique grâce à une justification fallacieuse, en oubliant de remarquer que la totalité du différentiel entre la France et l'Allemagne en termes d'émissions dues à l'énergie (4.5t par habitant ou encore une division par 2) est dû à l'emploi de nucléaire d'un côté et de charbon de l'autre. La deuxième, c'est l'apathie: après tout si c'était déjà écrit en 1979!

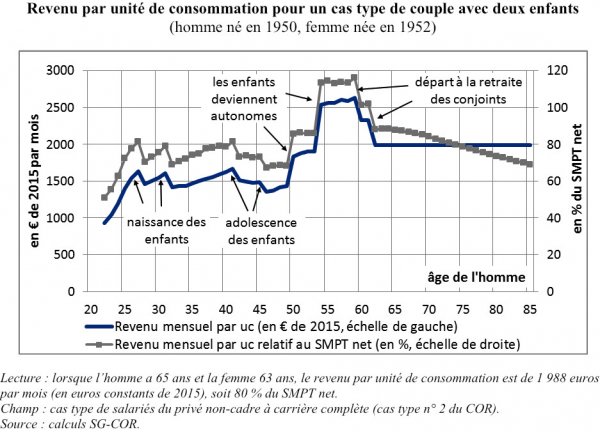

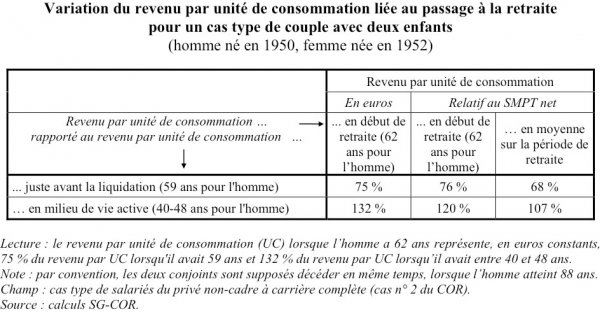

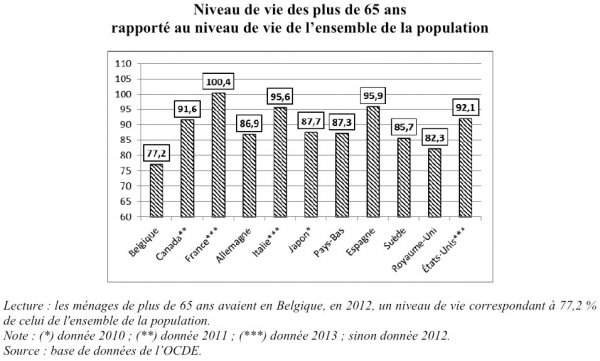

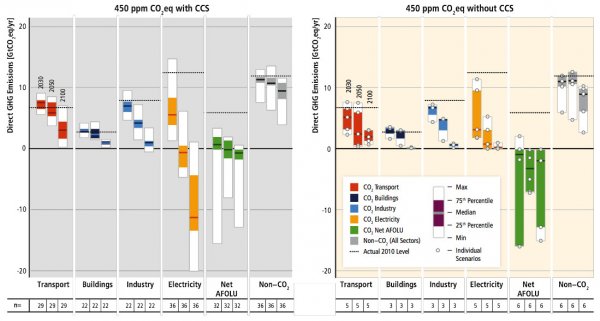

Le discours autour du réchauffement climatique est pour une bonne part capturé par les écologistes qui y recyclent leurs thèses répétées depuis les années 70: excès de population, opposition au nucléaire, opposition à la consommation, opposition à l'agriculture autre que biologique, soutien aux énergies renouvelables, soutien aux économies d'énergie. Si certains de ces thèmes sont évidemment favorables à la réduction des émissions, comme les économies d'énergie, d'autres vont totalement à l'opposé, comme l'opposition au nucléaire. Surtout, comme ce programme suppose une forte baisse du niveau de vie des habitants, il n'a aucune chance d'être appliqué volontairement dans une démocratie. Il n'est qu'à voir ce qui est arrivé à François Hollande: le niveau de vie des Français s'est détérioré lors des premières années de son mandat ce qui l'a sans doute conduit à ne pas se représenter! Le GIEC n'y échappe pas avec le tome 4 du rapport dont la figure 4.3 (p73) qui prend comme exemple le fait pour les Indiens de se déplacer plus à pied et le fait pour les Britanniques d'habiter dans de plus petites maisons. On y trouve aussi un encadré prenant au sérieux le Bhoutan et son bonheur national brut (p109). Que la lutte contre le réchauffement climatique n'ait fait aucun progrès n'a alors rien que de logique: les pauvres sont attirés par un plus fort niveau de vie comme en Chine, les riches se perdent en mesures défavorables comme la fin du nucléaire en Allemagne.

Un programme plus pragmatique reprendrait sans doute les mesures suivantes dans le cas français. Pour la production d'électricité, il est important de garder toutes les centrales nucléaires ouvertes de façon à maximiser la production d'électricité sans CO₂. Lorsqu'on arrivera à la fin de la vie des réacteurs, il faudra les remplacer par des moyens qui polluent au global aussi peu, ce qui oblige de fait à considérer comme probable le maintien de la puissance nucléaire pour une très longue durée. Prévoir une marge de production permet aussi de faire basculer des usages aujourd'hui émetteurs de gaz à effet de serre vers l'électricité.

Dans le secteur des transports qui représente environ 30% des émissions de gaz à effet de serre, l'électrification est freinée par les coûts des voitures mais aussi le manque de prises dans les garages. En effet, tous ceux qui habitent dans des immeubles avec garage n'ont pas de prise … ce qui les oblige de fait à continuer à utiliser un moteur à essence. Les véhicules hybrides rechargeables sont aussi un bon moyen de limiter les émissions, car la plupart des voyages se font aux alentours du domicile. Avoir une batterie assez limitée permet typiquement d'utiliser le moteur électrique pour aller au travail et le moteur à combustion interne pour partir en vacances. Il faut aussi accepter que les voitures électriques ou hybrides seront plus lourdes que celles à essence: une Renault Zoé pèse presque 1.5 tonne alors qu'une Clio pèse environ 1.2t; un Kangoo normal pèse 1.3t à vide, un Kangoo ZE presque 1.6t! En sus de la nécessaire hausse des prix des carburants, il faudrait aussi trouver le moyen de généraliser les prises de recharges pour tous … et accepter que de gros 4x4 dissimulent de grosses batteries.

Dans le secteur du chauffage des logements qui représente aux alentours de 25% des émissions de gaz à effet de serre, il faudrait cesser de considérer le diagnostic de performance énergétique pour se concentrer uniquement sur les émissions de CO₂. En effet, nombre de logements notés F ou G au diagnostic énergétique sont chauffés à l'électricité et ont donc une note nettement meilleure en terme d'émissions. Le même remarque vaut pour les normes de construction, où les émissions de CO₂ devraient définir ce qui est acceptable et non la quantité d'énergie dépensée. Cela conduirait à s'attaquer aux chauffages au fioul, combustible qui pollue le plus au kWh consommé.

Dans le secteur agricole, les émissions (environ 20% du total) sont dues à d'autres gaz comme le méthane (digestion des ruminants…) ou le N₂O (épandage d'engrais). Si on veut plus de méthanisation, il faut regrouper les fermes pour amortir l'investissement, ce qui est un anathème pour les écologistes. Les épandages d'engrais ne peuvent être diminués que si on trouve des solutions de remplacement, mais l'opposition générale aux OGMs bloque bon nombre de possibilités! Toujours est-il qu'il est extrêmement difficile de réduire les émissions dans ce secteur. Il en va de même dans bon nombre de secteurs de l'industrie lourde: en dehors de la capture du CO₂, il n'y a rien d'autre de possible pour la sidérurgie, la fabrication de ciment et d'aluminium.

Comme on peut le voir, les mesures pragmatiques sur la diminution des émissions s'éloignent du discours écologiste classique où on tape sur le nucléaire, le chauffage électrique, les SUVs, les grosses exploitations agricoles. Il faudrait sans doute plus défendre le nucléaire, faire la chasse aux citernes de fioul, poser des prises dans les garages, accepter des tanks électriques sur les routes et encourager les agriculteurs à se regrouper!

Derniers commentaires